Salta 发表于 2023-1-4 18:27

日200W数据,也不是很大,确实可以用PHP实现的。

luoluo 发表于 2023-1-4 18:43

但是有2个小时并发数据高。

Salta 发表于 2023-1-4 18:51

Redis单机写 每秒8W次, 读每秒11万次,你在担心什么?

PHP,就算撑不住你也可以上DNS轮训吧。

vihs 发表于 2023-1-4 19:05

担心是多余的,买阿里云,腾讯云的数据库集群,KV集群。 直接上,性能扛不住直接找云客服官方,比啥都强。 ...

whiler 发表于 2023-1-4 19:09

写入 20万/分,基本达到 8 核 32G 内存独服跑 MySQL 8.0 的上限了,和 PHP 无关,上队列吧,削峰填谷,或者 ...

whiler 发表于 2023-1-4 19:09

写入 20万/分,基本达到 8 核 32G 内存独服跑 MySQL 8.0 的上限了,和 PHP 无关,上队列吧,削峰填谷,或者 ...

luoluo 发表于 2023-1-4 20:33

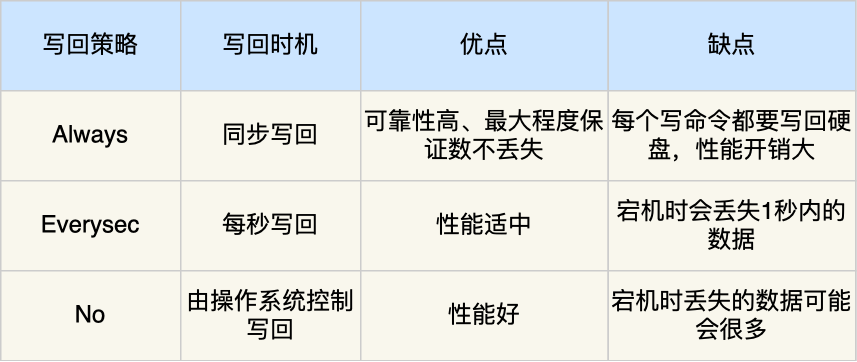

不是担心redis撑不住,是担心如果宕机了,redis会丢数据呢

luoluo 发表于 2023-1-4 20:39

对呀,就是考虑列队,不知道laravel支持redis列队,不知道这个方案若是在宕机情况下,能不能保证数据安全 ...

luoluo 发表于 2023-1-4 20:35

运维不熟悉的我一开始也这么想,想到一天能产生10g左右的数据,这个方案成本有点承受不住 ...

vihs 发表于 2023-1-4 21:01

你的想法恰恰相反。

1、这么大数据量,更需要数据安全,公司又不是你的,不需要你考虑成本。你替公司省 ...

luoluo 发表于 2023-1-4 20:39

对呀,就是考虑列队,不知道laravel支持redis列队,不知道这个方案若是在宕机情况下,能不能保证数据安全 ...

zlwzlx 发表于 2023-1-5 17:28

laravel 的性能不是强行 需要做好心理准备,这种数据量 设计时就应该考虑 程序可分布式运行,性能不行就堆 ...

MukaichiMion 发表于 2023-1-5 18:51

关键是看数据是怎么来的,是通过HTTP接口来的还是怎么来的

如果是HTTP接口的话,直接用负载均衡就可以搞定

...

拉斯 发表于 2023-1-5 17:30

算下来每秒不到一万,数据库没问题,不知道你这个日志是怎么产生的,如果不是访问一次接口产生一条日志用ph ...

luoluo 发表于 2023-1-6 18:04

mysql数据库每秒2000插入就已经差不多了吧

拉斯 发表于 2023-1-5 17:30

算下来每秒不到一万,数据库没问题,不知道你这个日志是怎么产生的,如果不是访问一次接口产生一条日志用ph ...

奧巴马 发表于 2023-1-5 17:41

PHP做过每秒并发3万(写入肯定不止3万,单日志就3万了).

放内存里面跑,然后主从分,每月分一次表. ...

| 欢迎光临 全球主机交流论坛 (https://91ai.net/) | Powered by Discuz! X3.4 |